HUE (HSV컬러모델)

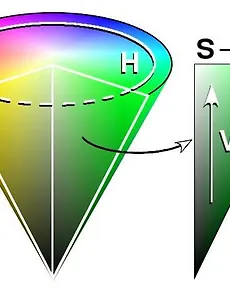

영상처리를 하다보면 HSV 라는 컬러모델을 접하게 되는 경우가 많다. 우리가 평소에 접하는 컬러모델은 RGB 라서 그런지 조금은생소한 느낌이 드는 것은 사실입니다. RGB는 Red, Green, Blue 로 이루어진 컬러모델로써, 모든 컬러를 Red, Green, Blue 의 가산혼합으로 표현하는 방식입니다. 우리가 사용하는 모니터가 RGB를 사용하는 대표적인 장치라고 볼 수 있습니다. 그렇다면 HSV는 무엇인가요? Hue, Saturation, Value 로 이루어진 컬러모델로써 모든 컬러를 Hue, Saturation, Value 로 표현하는 방식입니다. 색상, 채도, 명도를 의미합니다. Hue 는 0~100도, Saturation 은 0~100퍼센트, Value 는 0~100퍼센트 입니다. Open..

2018. 5. 7.

HUE (HSV컬러모델)

영상처리를 하다보면 HSV 라는 컬러모델을 접하게 되는 경우가 많다. 우리가 평소에 접하는 컬러모델은 RGB 라서 그런지 조금은생소한 느낌이 드는 것은 사실입니다. RGB는 Red, Green, Blue 로 이루어진 컬러모델로써, 모든 컬러를 Red, Green, Blue 의 가산혼합으로 표현하는 방식입니다. 우리가 사용하는 모니터가 RGB를 사용하는 대표적인 장치라고 볼 수 있습니다. 그렇다면 HSV는 무엇인가요? Hue, Saturation, Value 로 이루어진 컬러모델로써 모든 컬러를 Hue, Saturation, Value 로 표현하는 방식입니다. 색상, 채도, 명도를 의미합니다. Hue 는 0~100도, Saturation 은 0~100퍼센트, Value 는 0~100퍼센트 입니다. Open..

2018. 5. 7.